robots.txt運用のベストプラクティスは以下のポイントに集約されます。

-

基本構文の正確な理解と記述

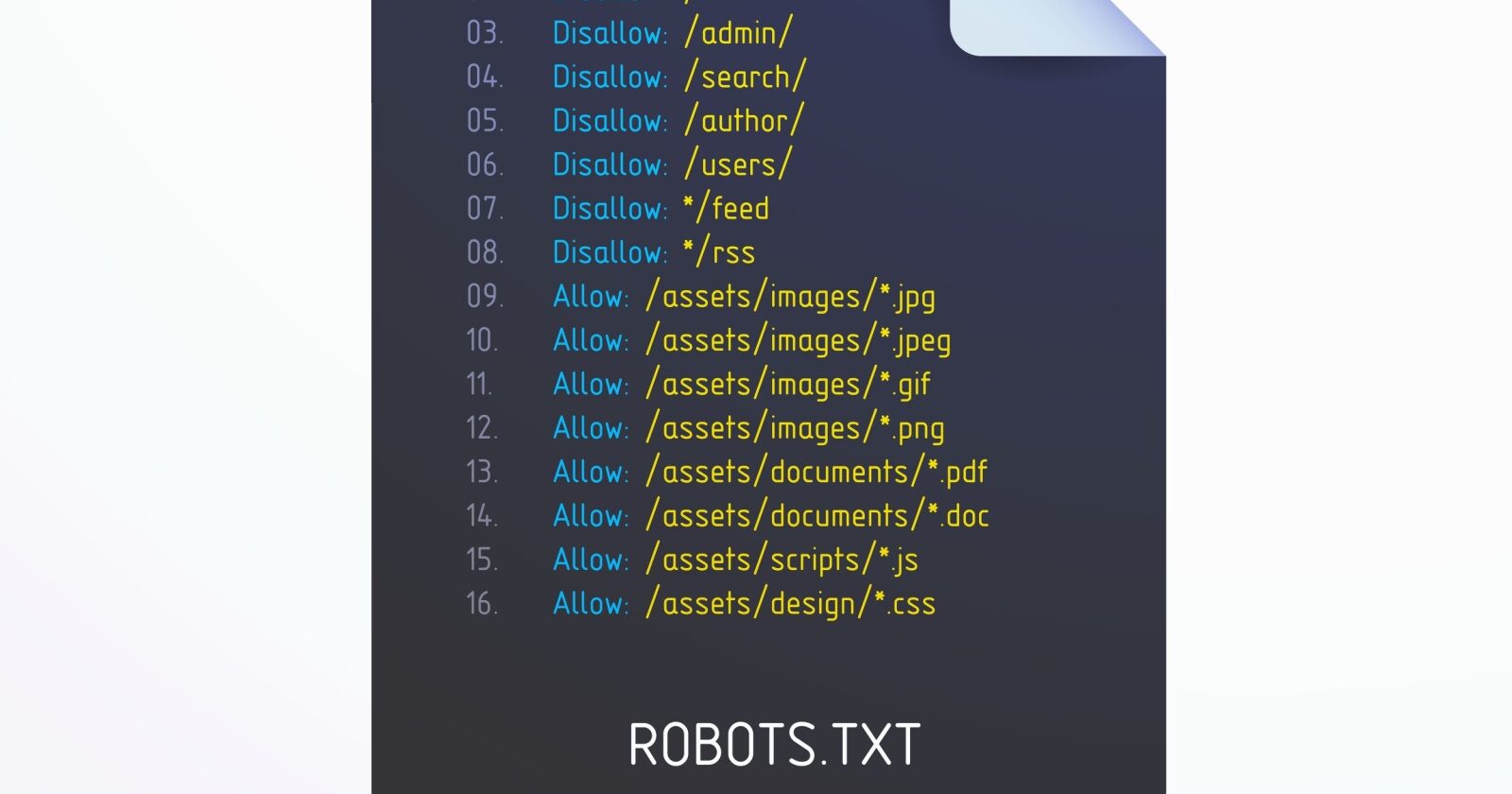

- User-agent(対象クローラー)を明確に指定する。

- Disallow(アクセス拒否パス)とAllow(アクセス許可パス)を適切に使い分ける。

- SitemapのURLを明示してクロール効率を高める。

例:

User-agent: * Disallow: /admin/ Disallow: /tmp/ Allow: /public/ Sitemap: https://example.com/sitemap.xmlこれにより、管理画面や一時ファイルなど不要な部分をクロールから除外しつつ、公開すべきコンテンツは許可できる。

-

ディレクティブは必ず新しい行に分ける

複数の指示を同じ行に書くと検索エンジンが正しく解釈できないため、必ず1行1指示にする。 -

ワイルドカード(*)やパターンマッチを活用して効率化

URLパラメータ付きのページや特定パターンのURLをまとめてブロックしたい場合は、ワイルドカードを使うと設定が簡潔になる。

例:User-agent: * Disallow: /products/*?これで/products/以下のパラメータ付きURLを一括で除外できる。

-

特定のクローラーごとに異なる制限を設定可能

GooglebotやBingbotなど、クローラーごとに異なるDisallowやAllowを設定し、細かく制御できる。 -

robots.txtとnoindexタグの使い分け

- robots.txtはクロールの制御(アクセス制限)に使い、

- noindexタグはインデックス登録の制御に使う。

両者を併用する場合は目的を明確にし、robots.txtでブロックしたページはGoogleがnoindexを認識できないため、インデックス除外したい場合はnoindexタグを使うべきページはrobots.txtでブロックしないように注意する。

-

テストと検証の徹底

- Google Search Consoleのrobots.txtテスターなどで設定ミスをチェックし、誤って重要ページをブロックしないようにする。

- 変更は一気に行わず、影響範囲を限定して段階的に適用するのが安全。

-

公開環境と開発環境での使い分け

- 開発中やステージング環境では全クロール禁止(Disallow: /)を設定し、公開環境では必要な部分だけ制限する。

これらのポイントを守ることで、検索エンジンのクロール効率を最適化し、SEO効果を最大化できます。robots.txtはサイトの構造や運用方針に合わせて柔軟に設計し、定期的に見直すことも重要です。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談