日本語URLや文字コードとrobots.txtの関係について説明します。

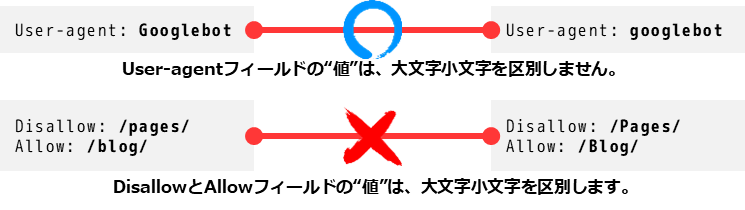

robots.txtは、検索エンジンのクローラーに対してクロールを許可・拒否するURLパスを指定するテキストファイルであり、URLパスは基本的にASCII文字列(英数字や記号)で記述します。日本語URL(日本語を含むURL)は、URLエンコード(パーセントエンコーディング)された形でrobots.txtに記述する必要があります。

具体的なポイント

-

robots.txtのURL指定はURLパスのASCII表現で行う

日本語など非ASCII文字を含むURLは、ブラウザやクローラーがアクセスする際にURLエンコードされます。robots.txtのDisallowやAllowで指定するパスも、URLエンコードされた形(%E3%81%82など)で記述しなければ正しくマッチしません。

例:日本語URL/カテゴリー/商品は/カテゴリー/商品のままではなく、/%E3%82%AB%E3%83%86%E3%82%B4%E3%83%AA%E3%83%BC/%E5%95%86%E5%93%81のように記述します。 -

robots.txtはUTF-8などの文字コードで保存されるが、URLパスはASCIIで指定

robots.txtファイル自体はUTF-8で保存して問題ありませんが、URLパスの指定はURLエンコードされたASCII文字列で行うのが標準的です。 -

正規表現やワイルドカードはASCII文字列に対して機能

robots.txtのDisallowやAllowで使える*や$などのワイルドカードは、URLエンコードされたパスに対して適用されます。 -

robots.txtはサイトのルートディレクトリに設置する必要がある

これは日本語URLの有無に関わらず共通のルールです。https://example.com/robots.txtに設置し、サブディレクトリには置けません。

まとめ

| 項目 | ポイント |

|---|---|

| 日本語URLのrobots.txt指定 | URLエンコード(パーセントエンコーディング)されたASCII文字列で記述する必要がある |

| robots.txtの文字コード | UTF-8で保存可能だが、URLパスはASCIIで指定する |

| ワイルドカード使用 | URLエンコード後のパスに対して有効 |

| 設置場所 | サイトルートのrobots.txtに設置必須 |

このため、日本語URLを含むサイトでrobots.txtを正しく機能させるには、日本語部分をURLエンコードした形でDisallowやAllowに記述することが重要です。そうしないと、クローラーが意図したURLを正しく認識できず、クロール制御が期待通りに働かない可能性があります。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談