robots.txtの作成方法は以下の4ステップが基本です。

-

テキストファイルを作成

「robots.txt」という名前でテキストファイルを作成します。ファイル名は必ず小文字で「robots.txt」とし、大文字や別名は使いません。 -

ルールを記述

ファイル内にクローラーへの指示を記述します。主な命令は以下の通りです。User-agent: 対象のクローラーを指定(例:Googlebotや*で全てのロボット)Disallow: クロールを禁止するパスを指定(例:/private/)Allow:Disallowで禁止した中の許可するパスを指定Sitemap: サイトマップのURLを指定し、クローラーの巡回を助ける

-

ルートディレクトリにアップロード

作成したrobots.txtは、Webサイトのルートディレクトリ(トップページと同じ階層)にアップロードします。サブディレクトリに置いても認識されません。 -

検証・テスト

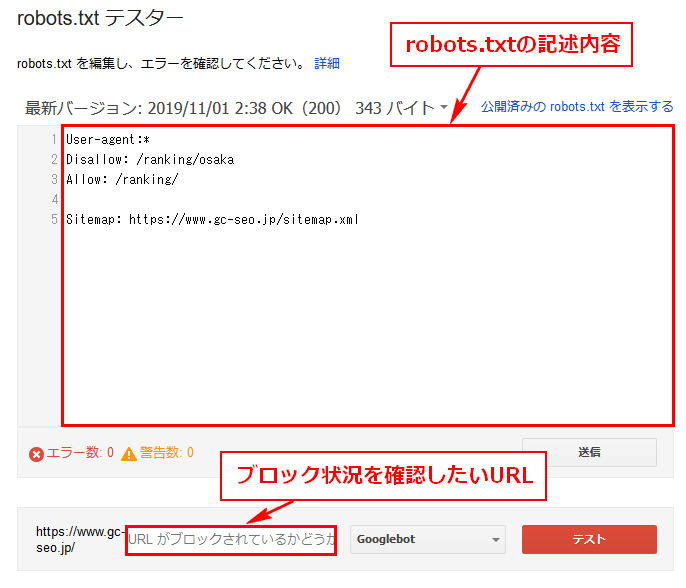

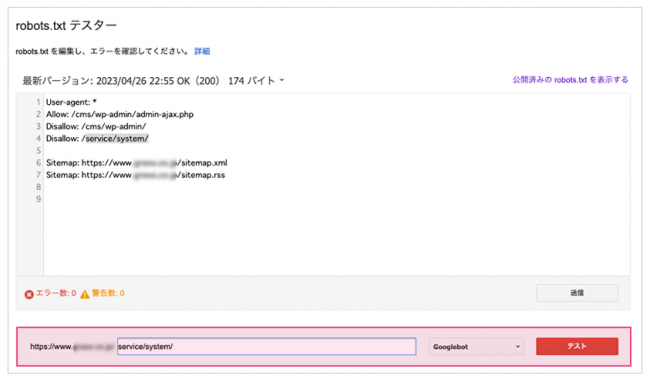

アップロード後、robots.txtが正しく機能しているかをテストします。Google Search Consoleの「robots.txtテスター」などのツールを使うと便利です。これにより、記述ミスや意図しないクロール制限を防げます。

robots.txtの検証やツール活用について

-

Google Search Consoleのrobots.txtテスター

Google公式のツールで、robots.txtの内容を入力・アップロード前にチェックし、特定のURLがクロール可能かどうかを確認できます。 -

オンラインのrobots.txtジェネレーター

テキストファイル作成が不慣れな場合、Web上のジェネレーターを使って簡単に記述を作成できます。 -

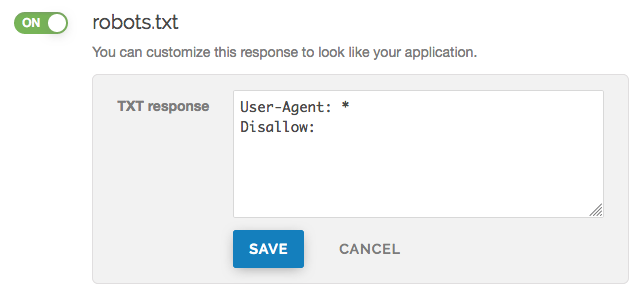

FastlyなどのCDNサービスの管理パネル

FastlyのようなCDNを使っている場合は、管理画面からrobots.txtのレスポンスを直接編集・カスタマイズすることも可能です。

まとめると、robots.txtは「robots.txt」という名前のテキストファイルを作成し、ルートディレクトリに置き、クローラーに対するアクセス制御ルールを記述します。作成後はGoogle Search Consoleなどのツールで検証し、正しく動作しているか確認することが重要です。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談