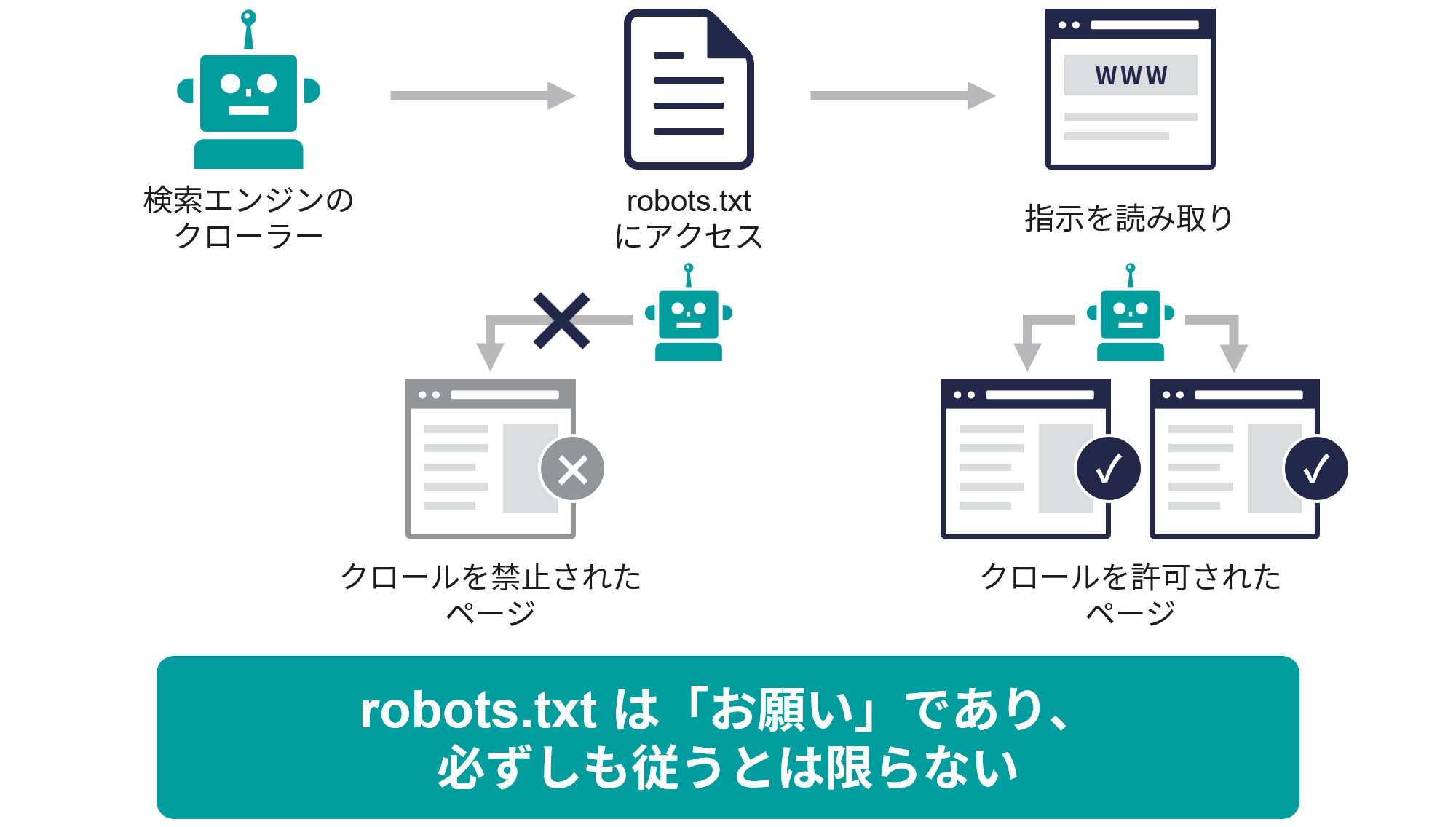

robots.txtで管理すべき典型的なページ種別は以下の通りです。

-

管理画面やログインページなどの非公開ページ

セキュリティ上クロールさせたくないページはDisallowでブロックします。 -

重複コンテンツが発生しやすいページ

URLパラメータで内容がほぼ同じページや、印刷用ページなどはクロールを制限し、重複インデックスを防ぎます。 -

検索結果ページやフィルタリングページ

クローラーに無駄なクロールをさせないため、これらの動的生成ページはブロックすることが多いです。 -

プライバシーポリシーや利用規約などの重要度が低い固定ページ

これらはSEO上の価値が低い場合、クロールを制限してクロールバジェットを節約します。 -

画像やCSS、JavaScriptなどのリソースファイル(必要に応じて)

ただし、Googleはこれらのファイルをクロールできることを推奨しているため、基本的には許可します。 -

サイト内の特定ディレクトリやファイル群

例として、管理用ディレクトリや一時ファイル置き場など、クロールさせたくないディレクトリを指定します。

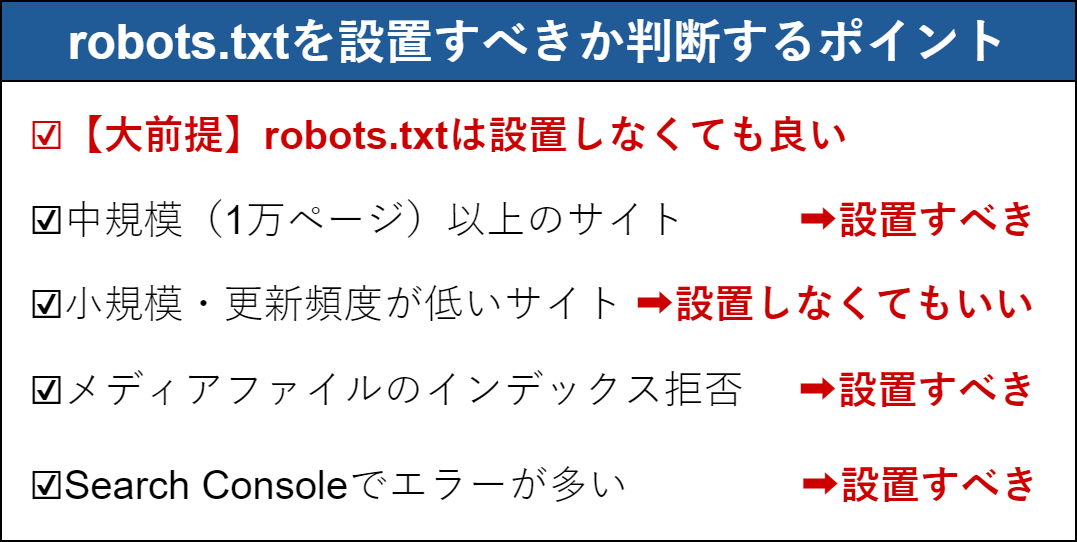

robots.txtは特に大規模サイトでクロールバジェットを最適化するために重要で、重要度の低いページをブロックし、重要なページを優先的にクロールさせる役割があります。また、robots.txtでブロックしているページをサイトマップに含めないよう注意が必要です。

具体的な設定例としては、

User-agent: *

Disallow: /admin/

Disallow: /login/

Disallow: /search/

Disallow: /tmp/

Allow: /blog/

のように、管理ページや検索結果ページをブロックしつつ、ブログなど重要なコンテンツは許可する形が典型的です。

以上のように、robots.txtでは「クロールさせるべきでないページやディレクトリ」を中心に管理することが一般的です。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談