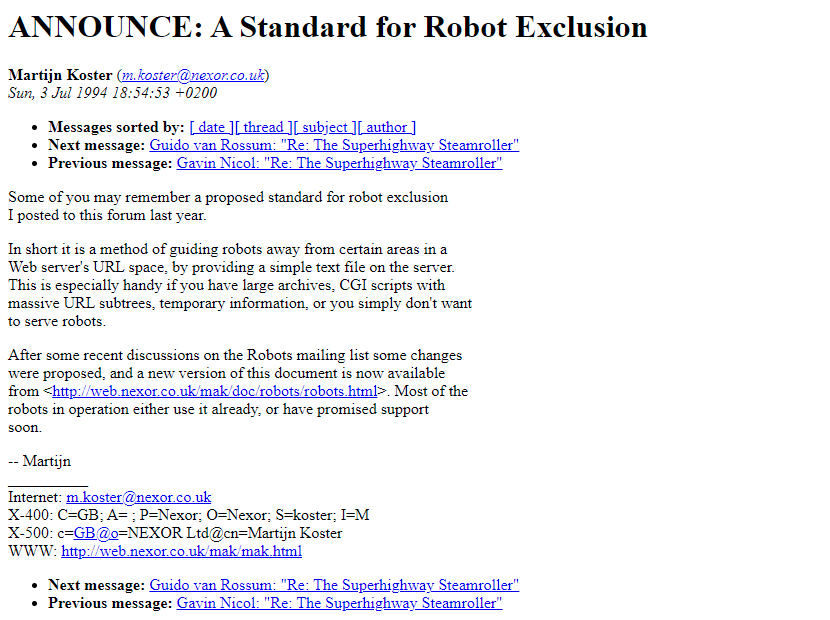

robots.txtは1994年にMartijn KosterがWebCrawlerのために考案した、ウェブサイト運営者が検索エンジンのクローラーのアクセスを制御するためのテキストファイルです。当初は特定のページやディレクトリへのクロールを拒否する簡単な手段として使われました。

1997年にはこの仕組みを標準化した「Robots Exclusion Standard(ロボット排除規約)」が策定され、robots.txtは広く一般的に利用されるようになりました。この規約により、サイト運営者はクロールを許可する範囲や拒否する範囲を明確に指示できるようになり、検索エンジンのクローラーはそれに従うことが期待されています。

2000年代以降、Googleをはじめとする検索エンジンのクロール技術も進化し、Googleは2006年頃から複数のサービスが共通のクロール基盤を使いながら、ユーザーエージェントを分けて識別する仕組みを導入しました。これによりrobots.txtの尊重やサーバー負荷の管理が一元化され、より効率的で予測可能なクロールが可能になっています。

さらに、2019年にはGoogleがrobots.txtの標準化をIETFで推進し、2022年にはRFC 9309として正式に提案されるなど、robots.txtの仕様はインターネット標準としての地位を確立しつつあります。

まとめると、robots.txtは1994年の発案から始まり、1997年の標準化を経て、検索エンジンの進化に伴いクロール制御の重要なツールとして発展し、近年は国際標準化も進んでいる技術です。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談