クロール予算の最適化とは、検索エンジンがウェブサイトに割り当てるクロール(巡回)リソースを効率的に使い、重要なページを優先的にクロールさせることを指します。クロール予算は無制限ではなく、特に大規模サイトでは不要なページのクロールを減らすことでサーバー負荷を軽減し、重要ページのインデックス化を促進します。

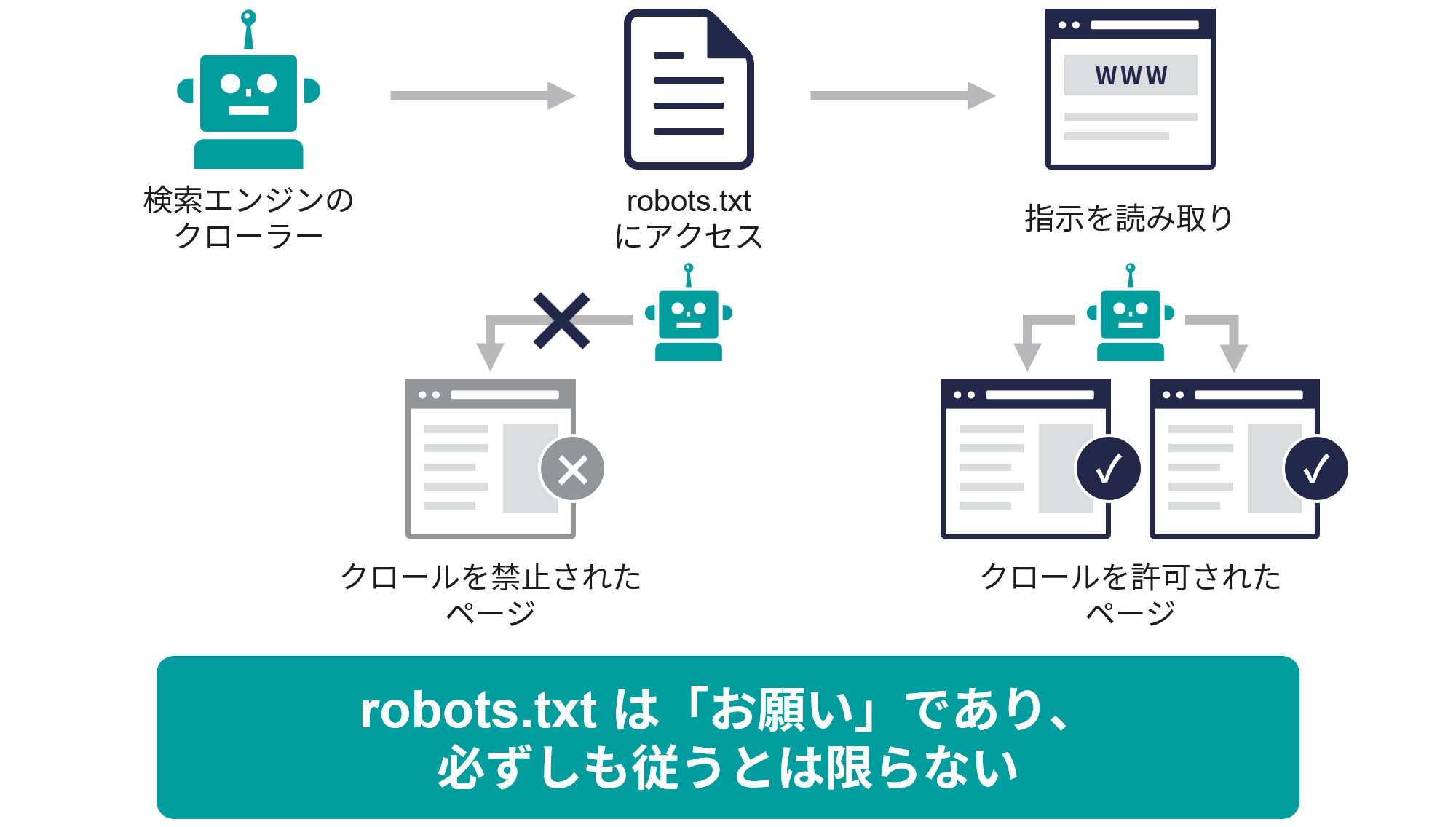

robots.txtの役割は、このクロール予算の最適化において非常に重要です。robots.txtファイルを使って、検索エンジンのクローラーに対し「クロールしてほしくないページやディレクトリ」を明示的に指定(Disallow)することで、不要なクロールを防ぎます。これにより、限られたクロール予算を価値の高いページに集中させることが可能になります。

具体的には、

- 重複コンテンツや検索結果ページ、ファセットナビゲーションなどクロール価値の低いページをrobots.txtでブロックする。

- サイトマップの場所をrobots.txtのSitemapディレクティブで指定し、クローラーに効率的な巡回を促す。

- Crawl-delayディレクティブでクロール間隔を調整し、サーバー負荷をコントロールする。

これらの設定により、SEO評価の最大化とユーザー体験の向上が期待できます。ただし、robots.txtでブロックしたページは検索結果に表示されにくくなるため、設定は慎重に行う必要があります。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談