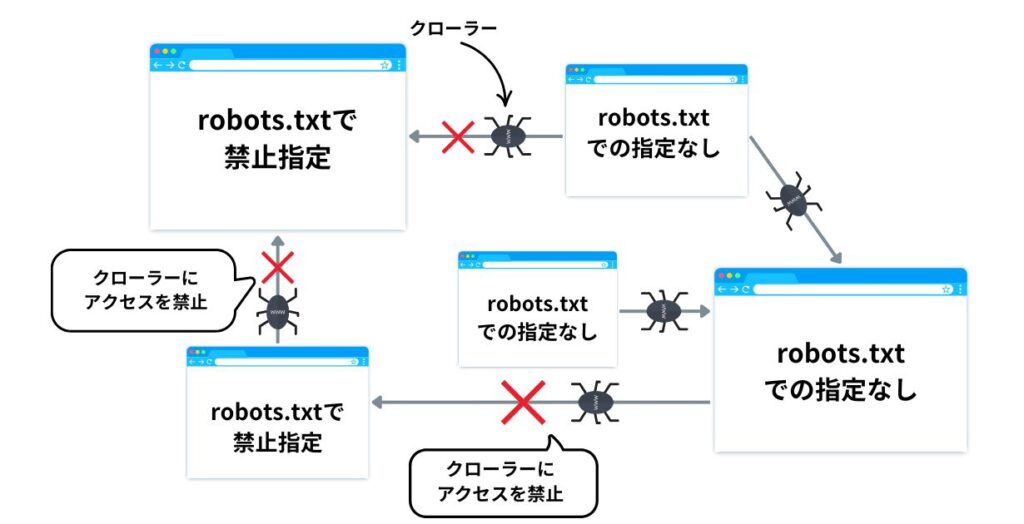

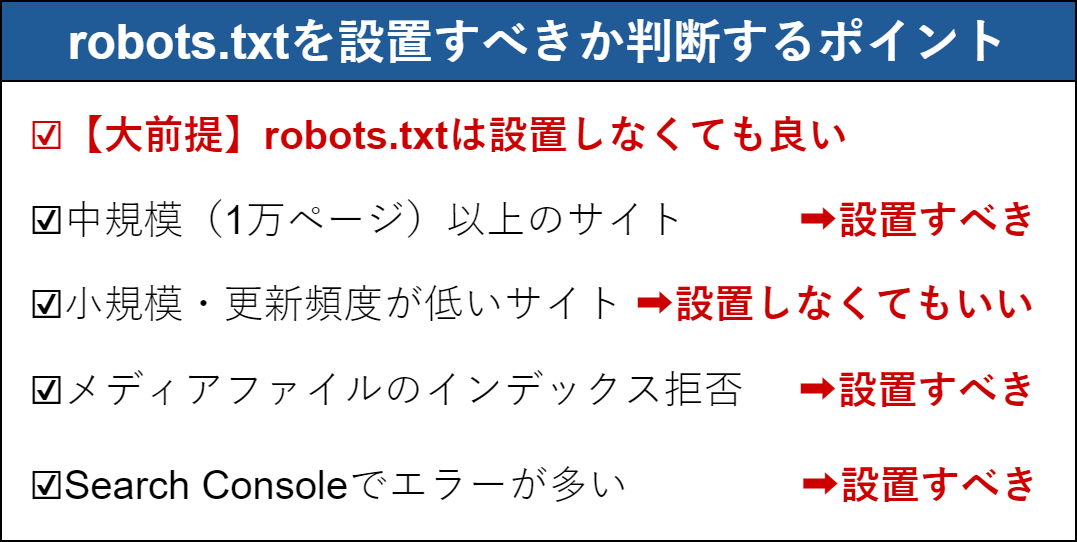

robots.txtの誤設定による主なリスクは、検索エンジンのクローラーがサイトの重要なページをクロールできなくなり、検索結果に表示されなくなることです。特に「Disallow: /」のように全サイトをブロックしてしまうと、サイト全体が検索エンジンから除外され、流入が激減する恐れがあります。

注意点としては以下が挙げられます。

-

クロール禁止の指定ミスに注意

意図しないページやディレクトリをDisallowでブロックすると、SEOに悪影響が出ます。特に全体ブロックは避けるべきです。 -

「robots.txtによりブロックされましたがインデックスに登録されました」というエラーの理解と対応

Googleがクロールできないページをインデックスしてしまう場合があり、robots.txtの設定を見直し、インデックスさせたいページはクロール許可する必要があります。 -

暫定的な対処法の活用

問題発生時は、特定クローラー(例:Googlebot)に対してDisallowを空にするなどの暫定対応も可能ですが、根本的な修正が望ましいです。 -

設定のテストと確認を必ず行う

robots.txtはテキストファイルで簡単に編集できるため、変更後は必ずGoogle Search Consoleなどでクロール状況を確認し、誤設定がないかチェックしましょう。 -

ドメインやホスティング環境の影響も考慮

特にCMSやホスティングサービスのデフォルト設定でrobots.txtが設定されている場合、意図しないブロックが起きることがあるため注意が必要です。

以上のように、robots.txtはSEOに直結する重要なファイルであり、誤設定は検索順位低下やアクセス減少のリスクを伴うため、慎重に設定・管理することが求められます。

JP Ranking は、日本で最高品質のウェブサイトトラフィックサービスを提供しています。ウェブサイトトラフィック、デスクトップトラフィック、モバイルトラフィック、Googleトラフィック、検索トラフィック、eCommerceトラフィック、YouTubeトラフィック、TikTokトラフィックなど、さまざまなトラフィックサービスをクライアントに提供しています。当サイトは100%の顧客満足度を誇り、安心して大量のSEOトラフィックをオンラインで購入できます。月額¥2600で、即座にウェブサイトトラフィックを増加させ、SEOパフォーマンスを改善し、売上を向上させることができます!

トラフィックパッケージの選択にお困りですか?お問い合わせいただければ、スタッフがサポートいたします。

無料相談